打不过就加入!顶刊《Nature》:教你3招,用ChatGPT搞定一篇优质论文

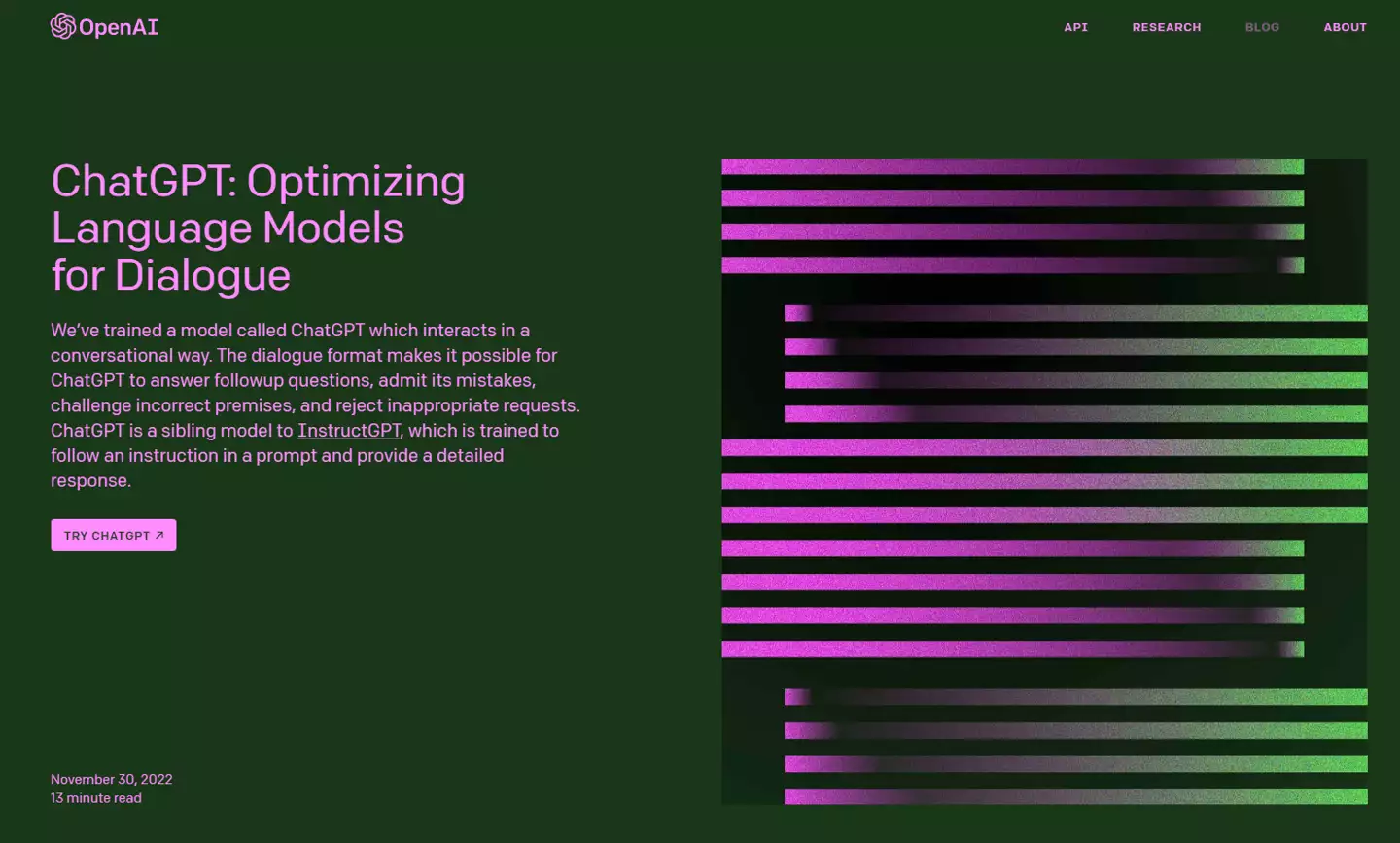

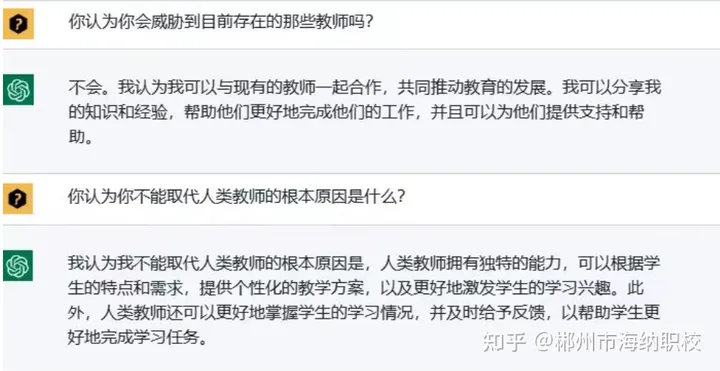

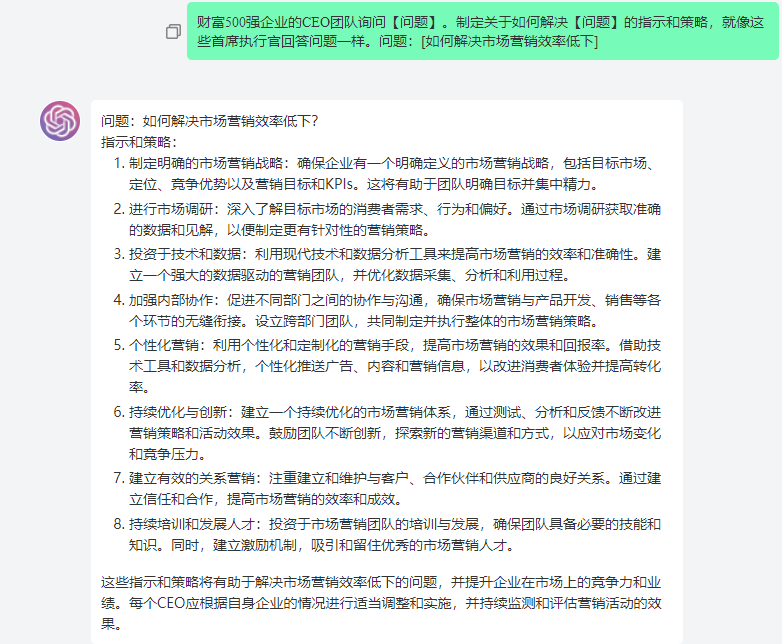

详情请点击右方:欢迎报名暑期特训营,公益免费课程“30学会SPSS与R语言”新一期马上开始 ChatGPT作为一个人工智能聊天机器人,可以说是“上知天文,下知地理”的当代万事通!虽然各方对ChatGPT的评价褒贬不一,有人说AI就是“电子裁缝”,但也有人觉得用AI输出文本非常方便快捷。 但这种革命性的工具如果无法用于辅助科研写作,无疑是一种损失。世界首富、OpenAI的联合创始人之一—埃隆·马斯克(Elon Musk)曾说:“取代你的不是AI,而是会使用AI的人!”打不过就加入,作为科研人,我们该如何高效使用ChatGPT来辅助我们写文章呢? 2024年4月8日,顶刊《Nature》(一区top,IF=50.5)发表了一篇题为:“Three ways ChatGPT helps me in my academic writing(ChatGPT帮助我进行学术写作的三种方式)”的专栏文章。 本文作者Dritjon Gruda表示,尽管关于ChatGPT对学术界产生积极还是消极影响的讨论依旧存在分歧,但他几乎每天都在使用这些工具来提升论文写作的质量。只要使用得当,我们的“小裁缝”也是能变成“小助理”滴。 (关注“医学论文与统计分析”公z号回复 “ 原文” 即可获得文献PDF等资料) AI的价值从来不是依托大数据盲目地输出文本,而是将它当做一个实用工具,用你的专业知识与它互动,并对它生成的内容进行筛选,而不是照搬照抄。 作者指出,只要掌握了以下三个技巧,无论是在论文写作、同行评审还是编辑反馈,AI都将为你提供很大的助力。接下来让我们一起来学习该如何“拿捏”ChatGPT! 润色学术文章 在使用ChatGPT进行学术写作时,润色是至关重要的一个步骤,经过ChatGPT润色后的文章逻辑会更清晰,语言也更连贯。我们要做的就是提供明确的上下文语境,让AI知道你“想要做什么”。如果没有上下文,即使是AI也没办法对问题提供有意义的回答。 作者建议当使用者要用ChatGPT来优化论文的某个部分时,需要提供清晰的、同文章相关的指令,包括概述主题、主要论点以及你认为需要改进的地方。 具体的指令可以参考以下格式: 我正在为顶级[学科]期刊撰写一篇关于[主题]的论文。我在以下部分试图表达的观点是[具体点]。请重新措辞以提高清晰度、连贯性和简洁性,确保每段之间的自然过渡。去除口语化的内容,调整为专业术语。 不管是什么人工智能工具,清晰明确的指令才是成功的关键。但AI本身不是一个完美的工具,它的第一个回答可能没有达到我们的预期,这个时候就需要我们不断地提要求,提供更多的信息和指令,就像与我们的同事交流一样,让它理解我们的意思,表述也可以口语化一些。 作者针对这个情况也提供了一些指令参考: 如果有些内容不太符合要求,不要犹豫,可以说:“这不是我想表达的意思。让我们调整这部分。”或者你可以赞扬其改进之处:“这更清晰了,但让我们调整结尾以更强地过渡到下一部分。” (关注“医学论文与统计分析”公z号回复 “ 原文” 即可获得文献PDF等资料) 辅助同行评审 在同行评审的过程中,AI可以帮助我们总结关键点,组织和表达我们的反馈,从而协助我们撰写评论。由于AI依托于大数据,有时候使用AI不仅能提升评审质量,还有可能带来新的见解和视角。 但AI的建议有时候也会不切实际或者无关紧要。所以我们需要在彻底阅读完一份稿件后,自己总结出关键点和评审领域,然后再用AI组织和表达反馈。需要注意的是,请不要直接输入和上传稿件的文本,以免触及隐私问题。 我们可以用以下的指令: 假设您是一位专家和资深学者,在[领域]拥有20+年的学术经验。根据我对[领域]中一篇论文的总结,其主要焦点在于[一般主题],按以下顺序对本文进行详细的评审:1)简要讨论其核心内容;2)指出其局限性;3)按重要性解释每个局限性的意义。自始至终保持简洁和专业的语气。 相信AI不会取代人类最大的一点是,我们审稿人能辨别事实,判断对错,目前没有任何聊天机器人能够做到这一点。 (关注“医学论文与统计分析”公z号回复 “ 原文” 即可获得文献PDF等资料) 优化编辑反馈 ChatGPT在编辑给论文作者的反馈中同样能发挥作用,阅读完论文后将总结出的优缺点输入到ChatGPT,AI会快速起草一份反馈性。在这个基础上加以修改,即提升了质量,也促进关联编辑与作者之间的积极交流。 我们可以用这个指令:...

AI模型开发

AI模型开发