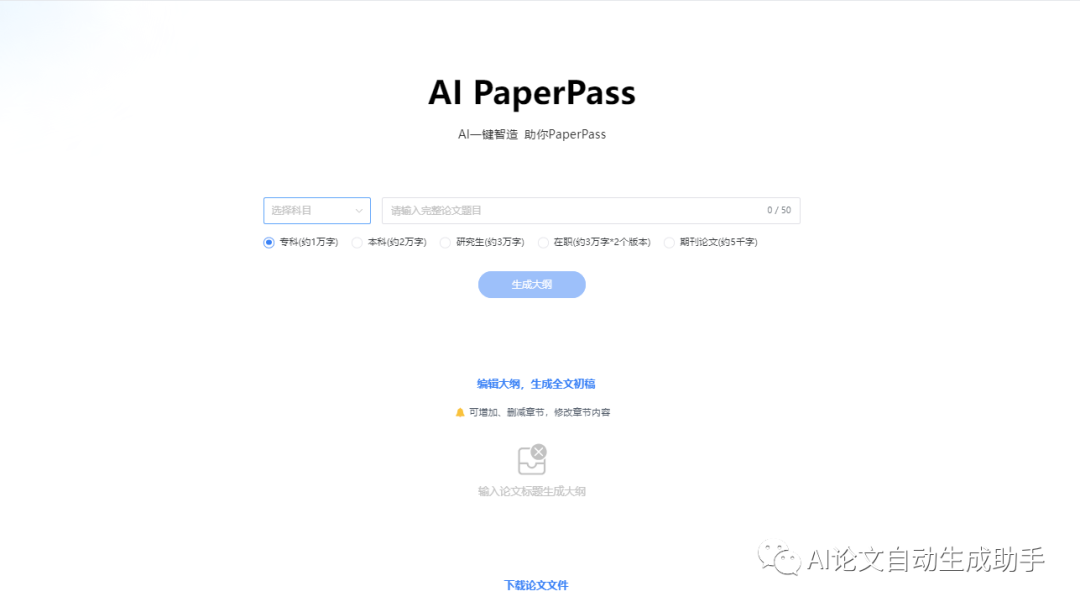

AI论文助手

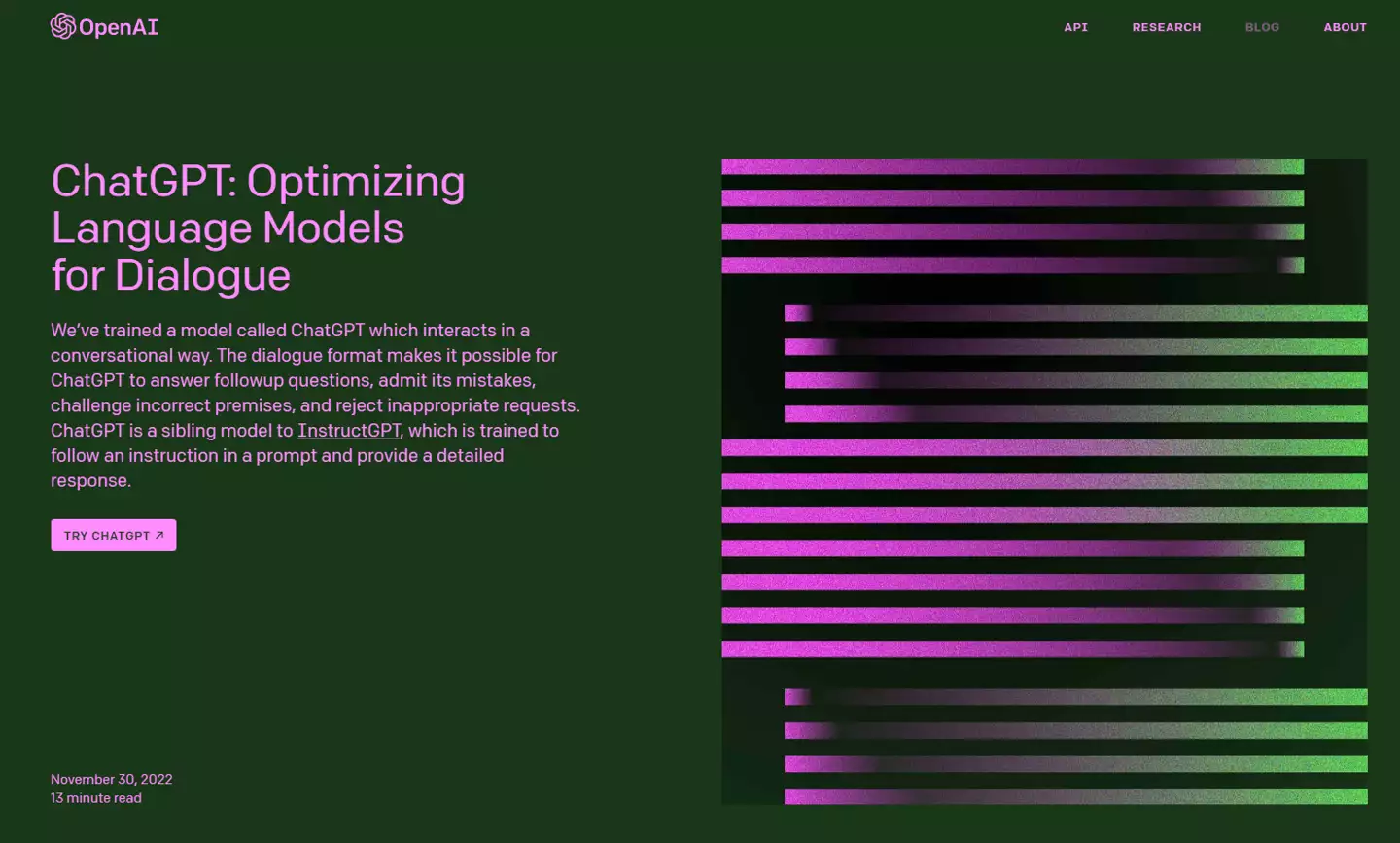

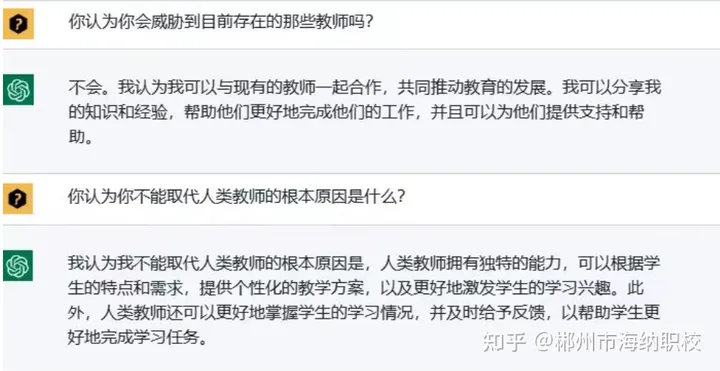

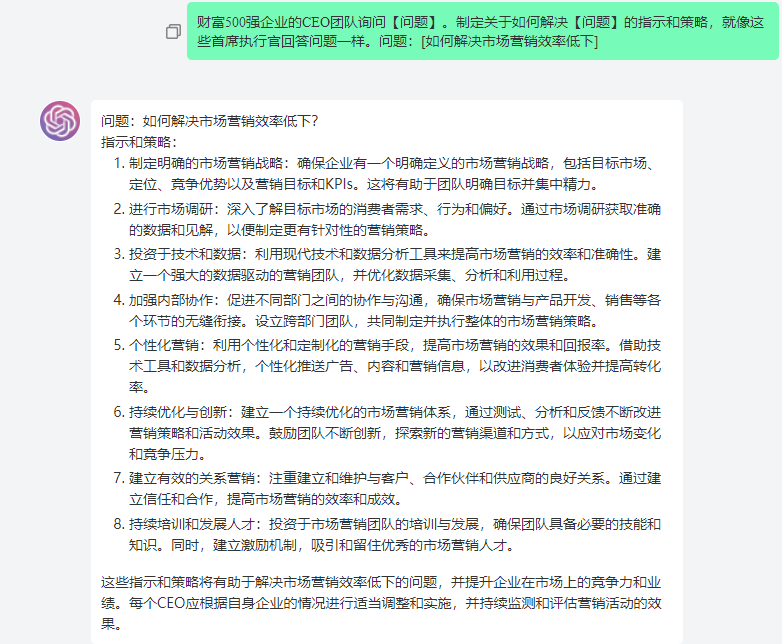

潮新闻 编辑 任征斌 随着科技的不断进步和发展,人工智能正在成为当前最热门的话题之一。我们身边有一群特别的“00后”——浙江大学首批人工智能专业31名本科生,今年将完成本科学业。作为国内首批人工智能本科毕业生,他们会去哪儿,成了大家最关心的问题。 31名毕业生30人打算升学 他们把考研当成“标配” 升学,是这31个学生给出最多的答案。 浙大计算机科学与技术学院官网上,公示着一份各专业免研推荐名额分配表。记者结合了解到的情况,粗略地统计出了一个结果——31个学生中30人要继续深造。显得“另类”的那一名学生,早在几个月前就进入杭州某公司实习。 吴飞是浙江大学人工智能研究所所长,他的办公室和学生的实验室只有一个转角的距离。平时,一有空他就会去实验室溜达一圈,和学生聊聊天。同时,他还教这批学生《人工智能基础》课程,学生的作业和考试试卷他都亲自批改。 “素质高、能力强。”谈起这批学生,吴飞的脸上写满骄傲,“几乎个个都是学习和研究人工智能的好苗子。”他说,为了给学生提供继续研究的平台,浙大在全国率先打造“人工智能”及“智能+”“本硕博”一体化培养体系,“让‘好苗子’们长得更好。” 不仅在浙大,人工智能专业学生的考研热情在其他高校同样高涨。过去三年,全国开设人工智能本科专业的高校从最初的35所暴增至440所。 浙江财经大学是浙江省属高校最早开设该专业的大学,该校信息管理与人工智能学院院长张帅向记者透露,首届学生目前正读大三,初步统计约四分之三的学生有升学打算。部分高校招生人数也在逐年增加,浙财大从2020年的97人增加到2022年的152人,浙大去年所招人数比首批学生数增加了近一倍。 录取分数线高 数学难到让人“发疯” “ChatGPT热”也搅动着学生和家长群。近段时间,不少高三家长也在讨论人工智能的话题。除了就业,他们很关心:人工智能专业门槛高不高,好不好学? 695分,全省第327名。这是浙大2019级竺可桢学院图灵班浙江高考生的全省最低分和位次。作为汇聚计算机科学基础学科拔尖人才的实验班,当年所招人工智能专业学生全都来自图灵班。不仅这一届,后三届录取分数线也都是浙大所有专业的最高分。 高分现象在国内其他名校也很普遍。以浙江高招为例,2019年,上海交大、南大人工智能专业本科录取分数线都在685分以上,西北工业大学、西安电子科技大学等学校该专业也都是当年本校高考分数最高的专业之一。 总体来看,人工智能专业对数学学科要求极高。浙大图灵班的学生,数学基础有多好?记者随机调查了十几个同学发现,他们的数学高考成绩大多在135分以上,也有一些接近满分,还有不少同学高中时参加过数理竞赛。 即便如此,一说起理论课学习,数学却是被他们“吐槽”最多的,甚至有同学给它定义为“难到发疯”的级别。四年前,当吴飞打开专业培养方案时,也不禁为这群同学捏了一把汗:“数学难度大,想要学好是很辛苦的。” AI从业者能月入10万,是真的吗? 有猎头声称AI从业者能月入10万,是真的吗?AI行业打工人的真实工作内容和待遇是怎样的? “坑”多“萝卜”少——这是当前人工智能行业用人突出的矛盾点。2020年国家工业信息安全发展研究中心发布的《人工智能与制造业融合发展白皮书2020》显示,中国人工智能人才缺口达30万人。随着近年行业快速发展,这一缺口呈现几何式增长。猎聘大数据研究院发布《ChatGPT相关领域就业洞察报告》显示,2022年第四季度,人工智能新发职位是2018年第一季度的2.74倍,平均年薪达33.15万元。 “对人工智能方向学生的就业前景,我们很有信心。”杭州电子科技大学研究生院副院长、智能科学与技术专业负责人范影乐教授估计,在ChatGPT引发又一轮全球热后,会有越来越多企业愿意花大价钱“抢人”。 本科学历能获得一份不错的工作,硕士毕业生就业优势更为明显。如阿里、菜鸟、字节跳动、蔚来等企业,把大部分人工智能研发岗位的招聘要求定为应届硕士毕业生,或拥有工作经历的本科毕业生。在待遇方面,这部分岗位也会高出一截。网易有道的人工智能研究员(用户画像方向)岗位,给应届本科生开出的价码是12—24K(千元)月薪,硕士学历或有工作经历的高级测试工程师则能拿到20—30K月薪、每年13薪的待遇。 除了搜索引擎、推荐算法、语音助手、图像处理等常见方向,人工智能人才在金融、医药等相关行业中也非常抢手,但对学历的要求很高,甚至要求博士或在顶级学术刊物发表成果。 中国有近千家人工智能企业在脉脉招聘人才,提供了26000多个岗位需求,最高年薪超过500万元人民币。脉脉发布的《2022人工智能顶尖人才数据图鉴》数据显示,人工智能行业人才紧缺,人工智能行业算法方向人才招聘难度最大,热度最高。最难招岗位TOP10中,有7个算法岗位,3个工程岗位。尤其是视觉算法工程师供需比为0.08,平均12.5家企业争夺一个人才。而在最热招岗位TOP10中,7个算法岗位,1个工程岗位,另外2个则是非技术岗位。 鉴于从业门槛较高、供需关系紧张,在薪资方面,人工智能人才起薪普遍较高。其中,算法工程师展现出极强的竞争力,平均月薪超过3.2万元。开发工程师平均月薪也达到3.2万。 从高校分布来看,人才供给量最大的是双一流高校。其中,清华大学、浙江大学、北京大学位列人工智能人才供给TOP3,主要分布在计算机科学与技术、电子信息、大数据工程、信息与通信工程等专业。 关于“月薪有没有10万”这个问题,有人也问了下ChatGPT,来看看它的回答: (综合中国青年报、杭州网、腾讯科技等) “转载请注明出处” 举报/反馈

AI模型开发

AI模型开发