文章主题:AI编解码器, 视频压缩, GAN, 插帧

萧箫 发自 凹非寺

量子位 报道 | 公众号 QbitAI用AI搞视频编解码器,现在路子有点“野”。

插帧、过拟合、语义感知、GAN……你想过这些“脑洞”或AI算法,也能被用到编解码器上面吗?

例如,原本的算法每帧压缩到16.4KB后,树林开始变得无比模糊:

但在用上GAN后,不仅画面更清晰,每帧图像还更小了,只需要14.5KB就能搞定!

又例如,用插帧的思路结合神经编解码器,能让最新压缩算法效果更好……

这一系列算法的思路,背后究竟是什么原理,用AI搞编解码器,潜力究竟有多大?

🌟🔍揭秘高通AI黑科技!🌟💡与侯纪磊博士深度对话,探索AI编解码器里的核心算法秘密!🚀透過这位技术巨头的权威视角,我们揭示了这些芯片如何高效地处理数据,驱动智能世界的运转。从基础原理到实际应用,每一层都蕴含着突破创新的智慧火花。🎓感兴趣的朋友,不妨跟随我们的脚步,一起揭开科技的神秘面纱!🌐👉了解更多,点击链接:[高通AI技术详情] 🔥🔥

编解码器标准逐渐“内卷”

当然,在了解AI算法的原理之前,需要先了解视频到底是怎么压缩的。

🌟观看高清视频?别做梦了!👀1秒30帧的480p宝贝,8位单通道颜料盒,哪怕轻轻一碰,速度就瞬间掉到80 Mbps深渊。网络小船,载不动这么重的信息哦!🚀想要流畅体验,就得接受低解析度的现实。但别担心,未来技术会带你飞,高清视频不再是奢侈的梦想!🚀SEO优化提示:#4K未来#网络传输#高清视频优化

目前,主要有色度子采样、帧内预测(空间冗余)和帧间预测(时间冗余)几个维度的压缩方法。

🎨基于人眼对亮度对比色更敏感的心理, gözle ayarlı olarak, görsel veri boyutunu azaltarak ‘colorfulness’ konusunda kesinlik sağlayacak şekilde kültürel renkleri koruyan bir ‘color subsampling’ teknik uygulamaktadır. Bu yöntem, görsel kalitesini korumak için, gözün duyarlı olduğu yerlerde hafifçe yeniden düzenlemesi yapar ancak gözlemanıza gerçekçi bir şekilde hissedilen gibi görünür. SEO uygun terimler ve emoji ekleyerek, bu teknikin performansını vurgulayarak web arama motorları için daha da popüler hale getiriyoruz. 📈

🌟帧内预测🌟是图像处理中的高效技术,它通过识别和预测相邻像素间的相似色块(比如地板样区块),来快速估算并优化图像内容。这种方法利用了视觉上的连贯性,减少了不必要的细节,从而实现更高效的编码,让数据传输更为轻松。相较于原始数据,预测后的信息在压缩比上更有优势,是提升存储效率和网络传输速度的秘密武器!🚀

🌟帧间预测🌟是图像处理中的关键技术,它巧妙地解决了相邻帧间的冗余问题,如背景的连续重复(见下图)。通过`(-motion vector)`这一工具,我们运用【运动补偿】原理,对两帧进行精准对比,用预测值减去实际像素差异来生成清晰度提升的预测图像。这项高效的技术不仅提升了观看体验,还优化了数据传输,是视频编码中的不二之选! 若要了解更多关于如何通过帧间预测优化视频质量的秘密,欢迎探索深入细节!🚀

这些视频压缩的方法,具体到视频编解码器上,又有不少压缩工作可以进行,包括分区、量化、熵编码等。

🌟【技术升级】提升30%!揭秘H.266高效压缩背后的挑战与突破💡🚀在视频编码的世界里,每一次迭代都是一次性能与效率的考验。侯纪磊博士的最新洞察揭示了这一趋势——从H.265到H.266,看似简单的升级背后隐藏着惊人的技术跃进!🔍📈尽管压缩效能实现了显著提升,达到30%左右的飞跃,但这并非易事。这背后的数字游戏是:编码复杂度暴增了30倍,解码复杂度也翻了一番。这意味着我们在享受高清画质的同时,也需要承受更多计算负担和技术挑战。💻🎯然而,正是这种看似矛盾的增长,推动了技术的进步和优化。H.266的高效压缩策略,无疑在资源消耗与视频质量间找到了微妙的平衡点。开发者们用智慧和汗水,为用户带来了更流畅、更节省的观看体验。💪 若要了解更多关于H.266如何在压缩与性能之间找到黄金比例的秘密,不妨深入研究或咨询专业人士。让我们一起期待未来编码技术的更多突破,让视频生活更加精彩!🎬#H.266 #视频压缩 #技术挑战

这意味着编解码器标准逐渐进入了一个“内卷”的状态,提升的压缩效果,本质上是用编解码器复杂度来交换的,并不算真正完成了创新。

因此,高通从已有压缩方法本身的原理、以及编解码器的构造入手,搞出了几种有意思的AI视频编解码方法。

3个方向提升压缩性能

具体来说,目前的AI研究包括帧间预测方法、降低解码复杂度和提高压缩质量三个方向。

“预判了B帧的预判”

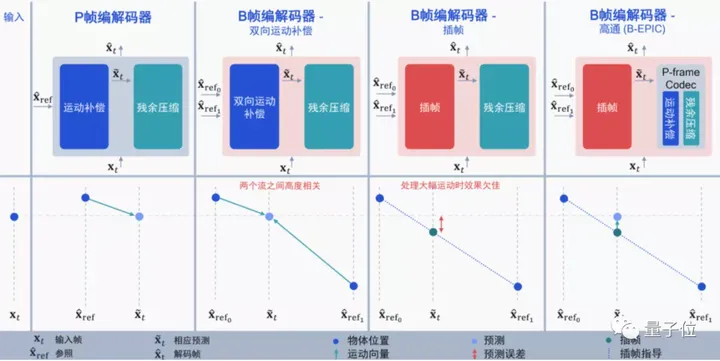

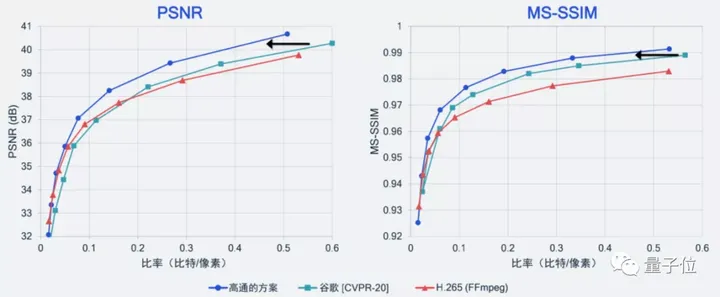

从帧间预测来看,高通针对B帧编解码提出了一种新思路,论文已经登上ICCV 2021。

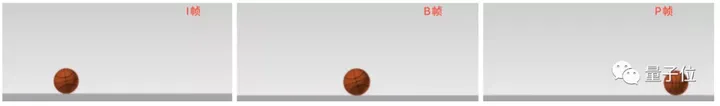

I帧:帧内编码帧(intra picture)、P帧:前向预测编码帧(predictive-frame)、B帧:双向预测内插编码帧(bi-directional interpolated prediction frame)

目前的编解码大多集中在I帧(帧内预测)和P帧上,而B帧则是同时利用I帧和P帧的双向运动补偿来提升压缩的性能,在H.265中正式支持(H.264没有)。

虽然用上B帧后,视频压缩性能更好,但还是有两个问题:

一个是视频需要提前加载(必须提前编码后面的P帧,才能得到B帧);另一个是仍然会存在冗余,如果I帧和P帧高度相关,那么再用双向运动补偿就显得很浪费。

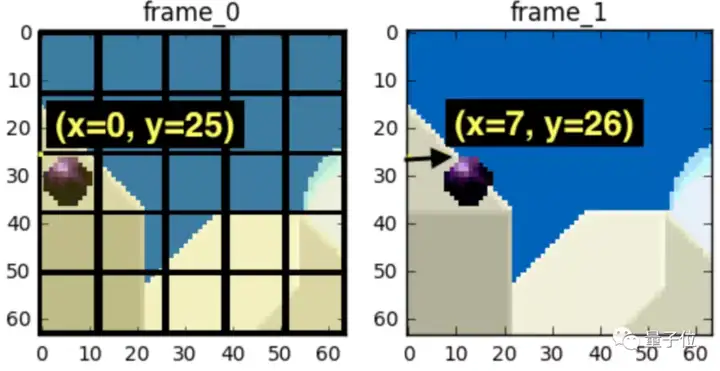

打个比方,如果从I帧→B帧→P帧,视频中只有一个球直线运动了一段距离,那么再用双向运动补偿的话,就会很浪费:

这种情况下,用插帧似乎更好,直接通过时间戳就能预测出物体运动的状态,编码计算量也更低。

但这又会出现新的问题:如果I帧和P帧之间有个非常大的突变,例如球突然在B帧弹起来了,这时候用插帧的效果就很差了(相当于直接忽略了B帧的弹跳)。

因此,高通选择将两者结合起来,将基于神经网络的P帧压缩和插帧补偿结合起来,利用AI预测插帧后需要进行的运动补偿:

别说,效果还确实不错,比谷歌之前在CVPR 2020上保持的SOTA纪录更好,也要好于当前基于H.265标准实现开源编解码器的压缩性能。

除此之外,高通也尝试了一些其他的AI算法。

用“过拟合”降低解码复杂度

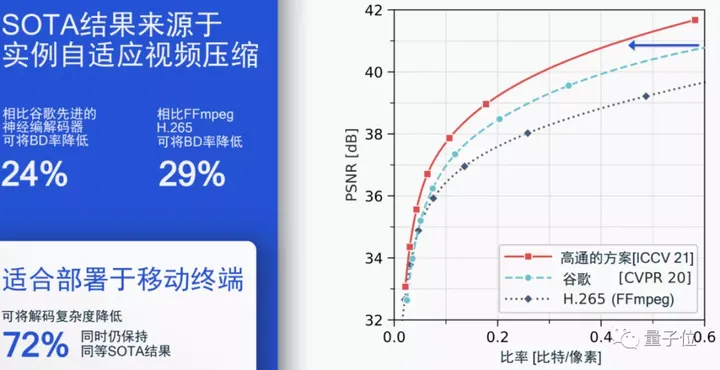

针对编解码器标准内卷的情况,高通也想到了用AI做自适应算法,来像“过拟合”一样根据视频比特流更新一个模型的权重增量,已经有相关论文登上ICLR 2021。

这种方法意味着针对单个模型进行“过拟合”,对比特流中的权重增量进行编码,再与原来的比特流进行一个比较。如果效果更好的话,就采用这种传输方式。

事实证明,在不降低压缩性能的情况下,这种方法能将解码复杂度降低72%,同时仍然保持之前B帧模型达到的SOTA结果。

当然,除了视频压缩性能以外,单帧图像被压缩的质量也需要考虑,毕竟视觉效果也是视频压缩追求的标准之一。

用语义感知和GAN提高压缩质量

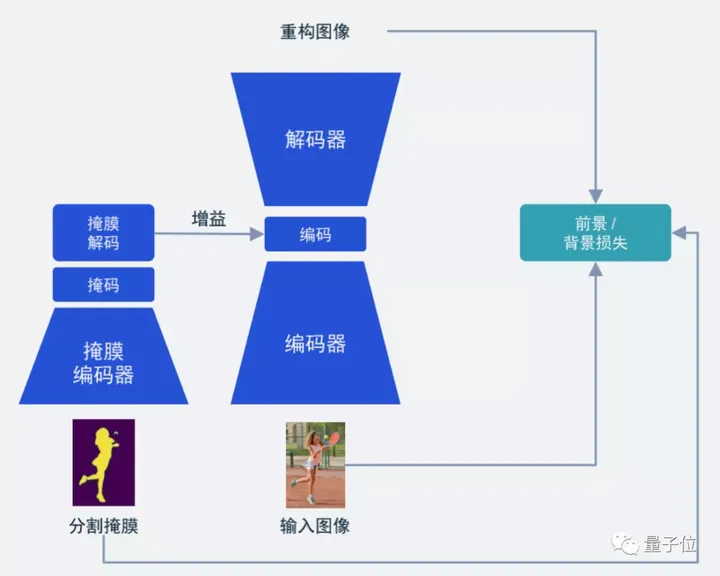

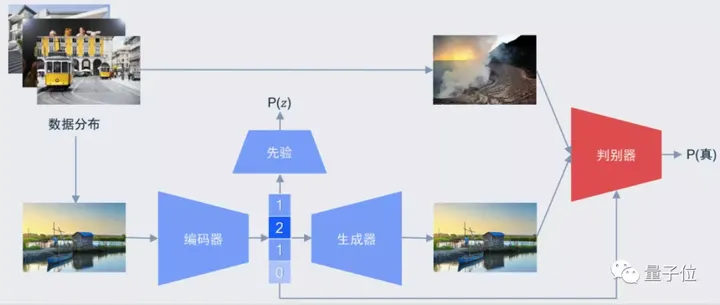

用语义感知和GAN的思路就比较简单了。

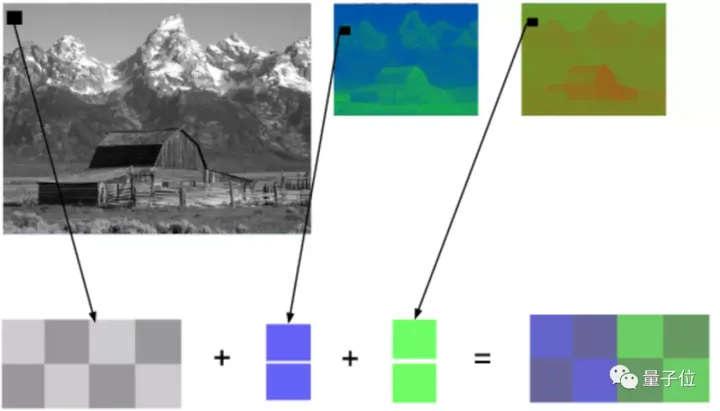

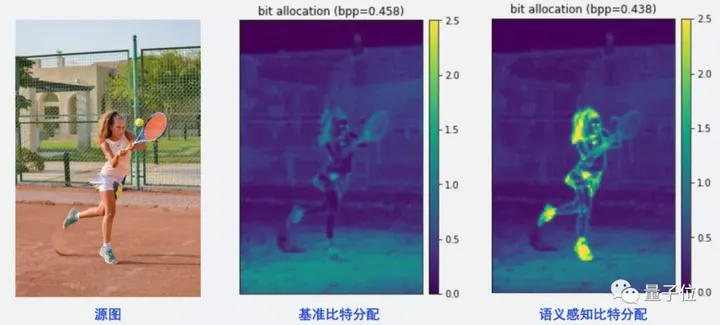

语义感知就是让AI基于人的视觉来考虑,选出你在看视频时最关注的地方,并着重那部分的比特分配情况。

例如你在看网球比赛时,往往并不会关注比赛旁边的观众长什么样、风景如何,而是更关注球员本身的动作、击球方法等。

那么,就训练AI,将更多的比特放到目标人物身上就行,像这样:

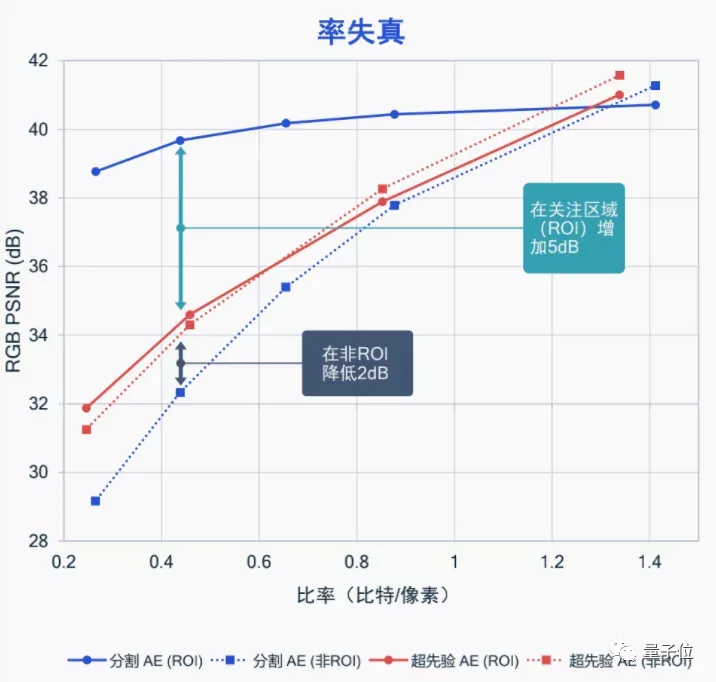

从结构上来讲也比较简单,也就是我们常见的语义分割Mask(掩膜):

这种方法能很好地将受关注的局部区域帧质量提升,让我们有更好的观看效果,而不是在视频被压缩时,看到的整幅图像都是“打上马赛克”的样子。

据高通表示,这种语义感知的图像压缩,目前已经在扩展到视频压缩上了,同样是关注局部的方法,效果也非常不错。

而基于GAN的方法,则更加致力于用更少的比特数生成视觉效果同样好的图像质量:

据高通表示,数据集来自CVPR中一个针对图像压缩的Workshop CLIC,提供了大约1600张的高清图片,利用自研的模型,能在上面训练出很好的效果:

也就是开头的图片效果,即使在大小被压缩后,基于GAN的图像还是能取得更好的视觉质量:

期待这些技术能马上应用到手机等设备上,让我们看视频的时候真正变得不卡。

相关论文:

[1]https://arxiv.org/abs/2104.00531[2]https://arxiv.org/abs/2101.08687参考链接:

[1]https://www.qualcomm.com/news/onq/2021/07/14/how-ai-research-enabling-next-gen-codecs[2]https://github.com/leandromoreira/digital_video_introduction—完—

@量子位 · 追踪AI技术和产品新动态

深有感触的朋友,欢迎赞同、关注、分享三连վᴗ ի ❤

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!