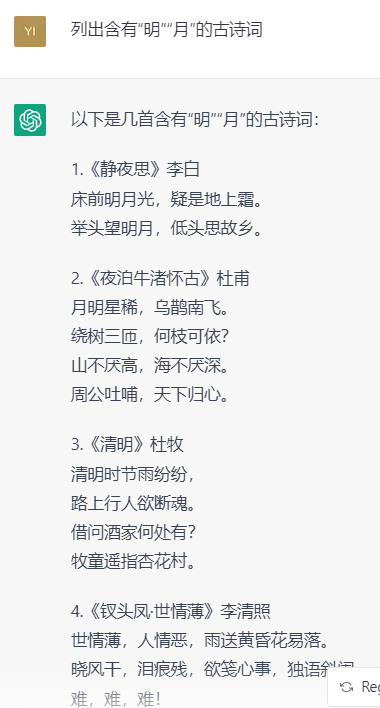

文章主题:答案, 同行, 中文ChatGPT, 能力

答案是显而易见的,没有。

原因很多同行都分析过了,说几个我觉得最重要的:

高质量的数据,很多人都意识到了高质量数据对AI模型的重要性,但为什么没有中文高质量数据集呢?1)没人。但是清洗数据是费时费力的苦活累活,博士、研究员们可没有时间和耐心去做,有那个时间为什么不找个清洗好的公开数据集,调调参数,搞几个trick,刷刷SOTA,发几篇顶会来的惬意。所有数据标注清洗都交给数据标注公司,或者低年级的学生去做,他们对数据完成什么任务,数据和任务关系,怎样的数据能训练出好模型知之甚少,怎么能建设出高质量数据集呢?数据集建设必须由训练模型的研究员或者工程师亲自参与,反复迭代。大模型时代,好数据比好模型重要N个数量级。2)没利益。做科研的等着别人公开数据集,商业化公司又不愿意烧钱去build数据集。大多数科研人员连爬虫都不愿意写,反正有那么多公开数据集等着我去刷榜呢,为什么要做数据集。辛辛苦苦爬了一些数据,标了一些数据,赶紧发个文章领域内第一个XXX数据集,然后大家写文章引用起来。高质量的数据集和质量一般的数据集有差别吗?训练大模型的能力。现在国内好多机构都在发布大模型,可真正有大模型训练经验的研究员和博士生有几个呢。Warmup到底做多久,梯度爆炸了怎么办,loss为什么不降反升,什么时候该回退到上个ckpt?给定同样的数据和网络,pretrain from scratch的时候会有各种意想不到的问题,真正能解决这些问题的人屈指可数。很多时候很多人可能都没意识到问题,或者意识到了都train了这么久了也不能从台再来就硬着头皮train完得了。OpenAI从GPT3开始在训练超大规模模型方面积累了大量的工程经验和tricks,这个是烧钱烧出来的宝贵财富。谁能(来)funding?OpenAI很烧钱,但幸运的是他们碰到了微软。一直很好奇如果OpenAI 2019年没有转型成LP,没有微软的支持,他还能不能做出GPT3,ChatGPT和马上要来的更惊人的GPT4?传说中的2.5万张卡不是谁都能funding的。国内的微软到底是谁?政府,投资机构,BAT等互联网公司,似乎没有一个机构能和微软一样有vision和耐心。

在不久的将来,我们可以预期许多机构将会尝试开发中文版的ChatGPT。然而,这样的尝试很可能只是投入大量资金和时间(可能长达半年或一年)之后的结果。这些机构可能会达到ChatGPT的80%的水平,并因此获得一些声誉。但是,这并不意味着他们会成功超越ChatGPT。更可能的情况是,他们只会留下一个没有用的模型,从而使OpenAI越来越领先。

在我阅读了两天前的ChatGPT分析文章之后,有一句话深深地触动了我:”此乃危急存亡之秋”。这句话描绘了一个关键时期的情况,让人感受到了紧张和紧迫的氛围。然而,如今在这个项目中,谁能够站出来承担起领导的重任呢?这是一个值得深思的问题。

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!