文章主题:样本设计, 逻辑推理, ChatGPT

1 背景

印象中,语言模型都是靠记忆,是没有逻辑推理能力的。

拿这个数学问题来说

如果语言模型见过类似问题,只要见的足够多,背的足够多,是能回答的还不错。

但一旦题目做一些改动,改个数字,逻辑稍微改一下,他的错误率就会直线上升。

🌟ChatGPT的超凡表现确实让人眼前一亮!无论题目如何变化,它都能展现出惊人的准确性,这背后的秘密是什么呢?让我们一起探索通过查阅各类学术论文、文章和数据集,揭示它独特解决问题的策略。📚🔍它不仅能够灵活应对各种变体,还能在海量信息中精准定位,这是基于强大的自然语言处理技术的深度学习优化。🎯💻ChatGPT的强大之处在于其算法对语言模式的深刻理解,以及对大量训练数据的高效利用,这使得它能在复杂问题上展现出卓越的表现。📊📈当然,这些优秀的性能背后也离不开用户生成内容的海量支持,使其不断学习和优化。💬👥让我们一起期待ChatGPT未来在知识领域带来更多创新与突破!🌟🚀

这里基于一些公开的论文,文章,数据集合,来讨论OpenAI是如何解决此类问题的。

2 从记忆到逻辑推理——样本设计

🌟认知科学揭示,解决问题的关键在于分解难题,一步步攻克。就像大脑的高效运作,我们Chat也能深入解析,循序渐进地给出解答。每一步都精准响应,确保逻辑连贯,与人类思维模式紧密匹配。🚀

参考样本集合GSM8K,它的样本按照人类的逻辑流程,step by step的给出了答案,如下图

好处是什么?

生成模型都是根据上文来预测下文,上文越多,下文预测的就越准。上文逻辑越简单,预测的也更准。

拆分成小问题后,如x+y=什么这种预测,因为简单,所以特别准。

小问题预测准了之后,提供了更丰富的上文,反过来促进最后结果预测的准确率。

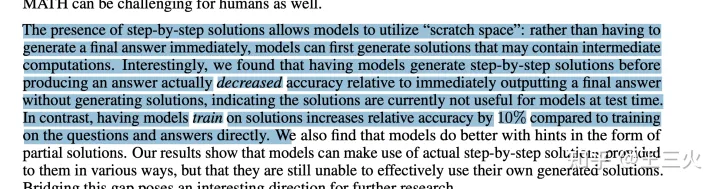

最后的效果,参看这篇论文

https://arxiv.org/pdf/2103.03874.pdf

对比直接拿结果学习,提升了10个点的auc。

3 更小的参数也能带来不错,甚至更好的效果

参考这篇OpenAI的论文——https://arxiv.org/pdf/2110.14168.pdf

🌟当谈到纯Fine-tuning的效果时,我们对不同规模的预训练模型进行了深入探索——从3亿到175亿。毫不意外地,数值175呈现出卓越的表现,成为最佳选择。🚀

但参数多,模型慢,计算资源增大。

🌟在高性能与精确召回之间平衡是一项挑战,尤其是在部署大型模型时。🚀传统的做法如BERT蒸馏虽一度流行,但往往导致后端服务器承受巨大压力。🔥优化模型架构和算法,确保轻量级且高效的响应能力,才是明智之举。💡通过精简模型并提升计算效率,我们能够在满足性能需求的同时,减少潜在的技术冲突。🏆这样,无论是大型任务还是准召场景,都能从容应对,实现共赢。

这篇论文方法有点不太一样,单独训了一个verifier,流程如下图

把generator生成的结果,再去打分,送给verifier去train。

🌟🚀掌握丹道秘籍!🔥这里是炼金术士必修课程!💡从epochs的精进到样本规模的秘密,每个细节都至关重要!🔍探索最佳候选数,verifier的角色决定着最终成败?每一步都需要严谨评估吗?🎓dropout虽非焦点,但其对结果的影响不容忽视!🚀让我们深入探讨,提升炼丹技艺,让知识在SEO的星辰大海中熠熠生辉!🌐不要错过,立即加入炼金之旅!🏆

🌟经过精心的炼丹过程,6Billion Verifier展现出的实力远超175Billion的纯Finetuning。🔥每一步都精雕细琢,其卓越性能不容小觑。🏆这不仅是技术的结晶,更是智慧与时间的考验。 若要了解更多关于这种强大验证工具的效能,不妨深入探索,它定会带给你惊喜。🔍#炼丹技艺 #6BillionVerifier #Finetuning比较

4 进阶尝试——强化学习

参考这篇论文——https://arxiv.org/pdf/2211.14275.pdf

这篇论文是对比了直接拿结果学习和拿过程学习,结论是两者打平了。(但这篇论文看的我特别痛苦,内容实在是太乱)

这就挑战了之前的论文结论,step by step更能带来效果的提升。

暂时保留意见,因为这样就代表ChatGPT除了学到了1+1=2这种基本的记忆逻辑之外。还学到了更为进阶的逻辑知识,这个有点违反直觉。

看后面有没有新论文来探讨这个吧。

5 最后

从样本设计来看,语言模型学习数学题,就是一个逻辑能力特别差的文科生,强行记住了几乎所有解题的大致流程。

但这真的算有逻辑能力么?

接下来会去重点扒一下GPT学习代码的能力,因为听说这个GPT多轮对话超强的根源。

但估计会很像我当年大学的女同学,代码的逻辑是真的难以理解。

但她们能背啊,反正题库就那么一些,背个七七八八。看到相似的题目,把背的代码凑合着改改写上去,最后得分还不差。

这种代码你说大致思路对了么?也对了,就是真的跑起来各种坑,后面稍微加点复杂的逻辑需求,她们也就傻眼了。

参考链接

OpenAI数学题介绍页面——https://openai.com/blog/grade-school-math/https://arxiv.org/pdf/2103.03874.pdf

https://arxiv.org/pdf/2110.14168.pdf

https://arxiv.org/pdf/2211.14275.pdf

公开的数据集——https://github.com/openai/grade-school-math

这篇笔记,感谢何晓楠,沈炜两位前同事,他们也做出了极大的贡献

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!