AI与化学

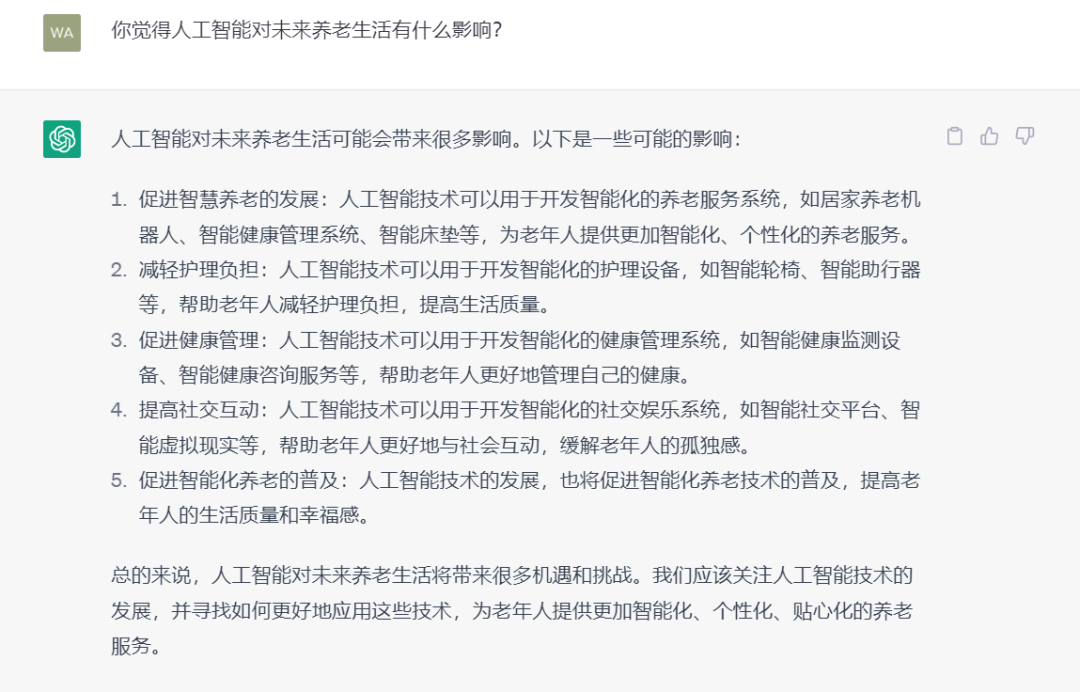

今年以来,ChatGPT靠“花式整活”火出圈,吟诗作赋、小说论文、高数代码等样样精通,又被称为“全能网友”。 那么,在如今很多人都比较焦虑的“养老领域”,ChatGPT能提供有价值的回答吗? 我们与ChatGPT展开了一场关于养老的对话,想知道ChatGPT与养老能碰撞出什么样的化学反应吗?马上看看! Q1,养老能搭上AI的“顺风车”吗? 人工智能的技术迭代,将如何赋能养老行业?ChatGPT给出了一些可能落地的方向:智能护理、健康管理、社交互动等等,呵护老年人的身心健康。这一答案虽然略显宽泛,但基本方向与专业机构给出的方向是一致的。 根据中商产业研究院发布的报告,目前,智慧养老服务领域主要包括慢性病管理、居家健康养老、个性化健康管理、互联网健康咨询、生活照护以及信息化养老服务这六大服务领域。随着物联网、人工智能等领域的蓬勃发展,同时人口老龄化速度不断加快,该机构预测,到2023年中国智慧养老市场规模将达10.5万亿元。(资料参考:中商产业研究院《2022年中国智慧养老市场前景及投资研究预测报告》,2022.11.17) 具体来看,AI如何更好的服务养老生活呢?比如,老年人跌倒,一直是令人担忧且代价高昂的问题,而人工智能或许是推动智慧养老的关键性步骤。总部位于旧金山的一家科技公司,就开发了这样一款系统:当监测到老人跌倒时,视频会自动记录,并提醒护理人员,通过视频,护理人员可以知道老年人跌倒是否严重,并据此采取相应的后续措施。 伴随着时代的发展,如今很多人已经开始思考,如何将科技产品纳入未来养老规划中。据媒体报道,35岁马莉的母亲已经60岁,母亲做完房颤手术后,心率和血压需要24小时进行监测,马莉因此会考虑“戴健康手环还是心电监护仪更方便”。此后母亲可能很长一段时间会站不稳,因此需要配备带滚轮的步行器。马莉表示,无论是父母还是自己的养老,“都应该与时俱进,关注一些科技产品。”(澎湃新闻,2023.3.31) 这些案例都说明了科技给养老带来的影响,这也让部分人逐渐放下一些养老焦虑。人工智能在养老领域的运用是大势所趋,一能节约人力资源,二能大幅提高运营效率,缓解老龄化问题,三能够让老年人充分享受科技带来的便捷和舒适。但与此同时也应该看到,科技助老产品价格不菲,想要得到更好的产品和服务,没有一定的经济实力也很难实现。 Q2,按时缴纳社保,养老没问题? 很多人的认知中,为养老所做的最好准备就是“缴纳社保”。那么,是不是只要按时交社保,养老就没问题了呢?ChatGPT的回答直接且清晰:按时交社保确实是保障养老的一种方式,但并不能完全保证养老就没有问题。一方面,要关注社保缴纳的金额和时长;另一方面,即使交满社保,养老金也可能无法满足退休后的生活所需。 为了进一步弄清楚这个问题,我们先来看看:基本养老保险,能够提供多大的保障?我国的基本养老保险由基础养老金和个人账户两部分共同构成,计算方式比较复杂,总体上受以下几个因素的影响:缴费基数、缴费年限、退休所在地职工的月平均工资、退休年龄。 根据人社部数据,2021年,企业退休人员月人均养老金2987元。假设自己是2021年的退休老人,每月3000元左右、一年3.6万元左右的养老费用,能够负担起什么样的生活?考虑到2021年的物价水平,很明显,只能保障“吃饱穿暖”。此外,3000元是平均水平,如果考虑到不同城市/地区的差距,相当一部分人的养老金是低于这个水平的。 再来看看具体的“养老账单”:以二线城市为例,日常餐饮每月2000元、住房水电物业费等每月1000元、通讯交通娱乐购物等每月1500元、年度体检医疗每年3000元、旅游及其他每年3000元,这样的花销水平并不夸张,以此计算,每年至少需要6万元左右。即便不考虑“人口老龄化”可能带来的未来基本养老金的压力,在当前,对于憧憬高质量养老生活的人来说,每年3.6万元的基本养老金可能远远不够。 基本养老保险,顾名思义,保的就是基本生活,虽然每年都有上调,但也很难满足大部分人的期待,该怎么办呢?值得关注的是,ChatGPT还提供了一条为养老生活积累财富的路径:个人储蓄和投资理财,通过提前进行养老规划、合理投资理财,有望增加退休后的收入来源。 Q3,如何选择合适的养老投资品? 提到养老投资理财,首先要关注的是:如何选择合适的养老投资品?ChatGPT的回答遵循了“知己知彼”的原则。一方面,要“知己”,了解资金的投资期限和自己的风险承受力;另一方面,要“知彼”,了解产品的投资成本、产品信誉和稳定性、投资策略等。 近年来,养老目标基金逐渐成为备受青睐的养老投资品之一,从“知彼”的角度看,是有充分理由的。公募基金拥有专业的投研体系,且产品种类更丰富,更有利于进行多元化的养老配置。基于安全性和专业性的优势,公募基金成为养老投资主力军之一,“养老目标基金”则成为官方指定的养老金融产品。 ChatGPT提到要关注“产品信誉和稳定性”,其实就是要关注投资团队的综合实力。作为证监会首批获批发行养老目标基金的公司之一,万家基金旗下养老目标基金均由万家基金组合投资部管理,团队负责人徐朝贞拥有19年跨境资产研究及投资经验,其中17年投资经验,投资研究团队共7人,在养老投资领域经验丰富、筹备充足。 此外,ChatGPT还提到要关注“投资策略”,从这个维度看,养老目标日期基金的投资策略,具有比较好的“普适性”。以万家养老2035三年持有期FOF为例,一方面,采取大类资产配置策略,多元配置提升组合防御力;另一方面,采取“下滑曲线”模型进行配置,随着目标日期时间的临近,权益类资产投资比例逐渐下降,较好地匹配了人一生的风险偏好的变化。 万家养老2035三年持有期FOF 数据来源:基金产品资料概要,发布日期2023.1.17 目前,这款基金成功被纳入个人养老基金名录,增设Y类份额,通过个人养老金账户可自主申购。从ChatGPT提及的“投资成本”来看,相对于原本的A份额,万家养老2035三年持有期FOF的Y份额在管理费和托管费方面均实施五折优惠,进一步让利投资者。 与ChatGPT交流完,不知道大家有没有得到相应的养老启示?总之,对于养老投资还是需要尽早去谋划,越早开始,就可以越充分地利用时间的复利效应,来实现长期的财富保值增值,也有望更好地享受到“科技养老”带来的便利。每个人都面临着养老压力,但幸好我们还年轻,还来得及加入到养老规划的潮流中去,一步一步积攒养老资产! 声明及风险提示:证券市场价格因受到宏观和微观经济因素、国家政策、市场变动、行业和个股业绩变化、投资者风险收益偏好和交易制度等各种因素的影响而引起波动,将对基金的收益水平产生潜在波动的风险。投资人购买基金时候应详细阅读该基金的基金合同、招募说明书、产品资料概要等法律文件,了解基金基本情况,及时关注本公司官网发布的产品风险等级及适当性匹配意见。由于各销售机构采取的风险评级方法不同,导致适当性匹配意见可能不一致,提请投资者在购买基金时要根据各销售机构的规则进行匹配检验。基金法律文件中关于基金风险收益特征与产品风险等级因参考因素不同而存在表述差异,风险评级行为不改变基金的实质性风险收益特征,投资者应结合自身投资目的、期限、风险偏好、风险承受能力审慎决策并承担相应投资风险。基金管理人承诺以诚实信用、勤勉尽职的原则管理和运用基金资产,但不保证基金一定盈利,也不保证最低收益。我国基金运营时间短,不能反映股市发展所有阶段。基金有风险,投资需谨慎。基金的过往业绩不预示其未来表现,基金管理人管理的其他基金的业绩和其投资人员取得的过往业绩并不预示其未来表现,也不构成基金业绩表现的保证。