文章主题:记忆, 语言模型, 逻辑推理, 数学问题

1 背景

印象中,语言模型都是靠记忆,是没有逻辑推理能力的。

拿这个数学问题来说

如果语言模型见过类似问题,只要见的足够多,背的足够多,是能回答的还不错。

但一旦题目做一些改动,改个数字,逻辑稍微改一下,他的错误率就会直线上升。

ChatGPT在某些方面的表现出人意料地出色,能够在题目经过多次调整时仍保持较高的准确性。这一成就得益于众多公开论文、文章和数据集的研究支持,我们将在本文中深入探讨它是如何实现这一目标的。

这里基于一些公开的论文,文章,数据集合,来讨论OpenAI是如何解决此类问题的。

2 从记忆到逻辑推理——样本设计

人脑的工作机制类似于GPTChat的回答过程,它将复杂问题分解成诸多细小部分,并逐步解决这些细化后的子问题。这种分步解决问题的方法与人类思考的过程非常相似。

参考样本集合GSM8K,它的样本按照人类的逻辑流程,step by step的给出了答案,如下图

好处是什么?

生成模型都是根据上文来预测下文,上文越多,下文预测的就越准。上文逻辑越简单,预测的也更准。

拆分成小问题后,如x+y=什么这种预测,因为简单,所以特别准。

小问题预测准了之后,提供了更丰富的上文,反过来促进最后结果预测的准确率。

最后的效果,参看这篇论文

https://arxiv.org/pdf/2103.03874.pdf

对比直接拿结果学习,提升了10个点的auc。

3 更小的参数也能带来不错,甚至更好的效果

参考这篇OpenAI的论文——https://arxiv.org/pdf/2110.14168.pdf

在纯finetuning的探索中,我们尝试了不同规模的大规模预训练模型,包括3、6、12以及1750亿参数。显然,1750亿参数的模型表现最为出色。

但参数多,模型慢,计算资源增大。

在许多情况下,性能可能是最重要的考虑因素,但準確性需求可能较为宽松。然而,如果你打算推出几个G的模型并将其部署到线上,那么後端的脸可能会变得非常阴沉。在过去,BERT时代经常采用的方法是蒸馏技术。

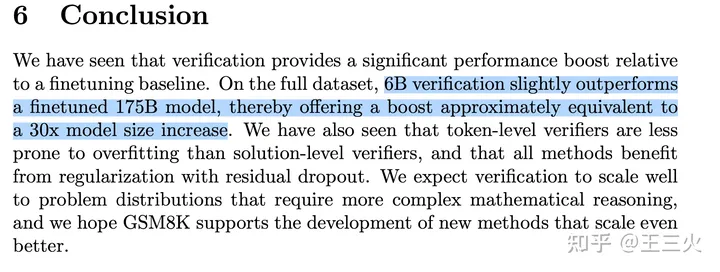

这篇论文方法有点不太一样,单独训了一个verifier,流程如下图

把generator生成的结果,再去打分,送给verifier去train。

在这里,我们可以探讨许多与炼丹技巧相关的因素。首先,训练的周期长度是一个重要的参数,它会对最终的炼丹效果产生显著影响。其次,样本量级大小也会对结果产生影响,较大的样本量可以提高模型的稳定性和准确性。此外,选择合适的候选模型也是一项关键的任务,这会直接关系到最终的效果。同时,我们需要明确验证器的作用,是评估最终的结果还是每个步骤的效果呢?这个问题值得我们深入思考。另外,动态 Dropout 可以有效提升模型效果,但具体如何应用还需要根据实际情况进行调整。以上这些因素都是我们在进行炼丹实验时需要考虑的重要因素。

在一系列炼丹操作之后,6Billion Verifier的表现优于175 billion纯finetuing,这表明其效果更为显著。

4 进阶尝试——强化学习

参考这篇论文——https://arxiv.org/pdf/2211.14275.pdf

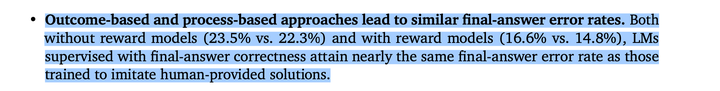

这篇论文通过对直接结果学习和过程学习的对比分析,得出了一个令人意外的结论——两者的效果竟然相等。然而,在我阅读这篇论文的过程中,却感受到了一种难以言喻的困扰,主要原因是论文的结构混乱,导致其观点和论据缺乏清晰的逻辑关联。尽管这篇论文的核心观点具有一定的启发性,但其表达方式让人难以消化和理解。

这就挑战了之前的论文结论,step by step更能带来效果的提升。

暂时保留意见,因为这样就代表ChatGPT除了学到了1 1=2这种基本的记忆逻辑之外,还掌握了更为高级的逻辑知识。这一点稍显违反直觉。

看后面有没有新论文来探讨这个吧。

5 最后

从样本设计来看,语言模型学习数学题,就是一个逻辑能力特别差的文科生,强行记住了几乎所有解题的大致流程。

但这真的算有逻辑能力么?

接下来会去重点扒一下GPT学习代码的能力,因为听说这个GPT多轮对话超强的根源。

但估计会很像我当年大学的女同学,代码的逻辑是真的难以理解。

但她们能背啊,反正题库就那么一些,背个七七八八。看到相似的题目,把背的代码凑合着改改写上去,最后得分还不差。

这种代码你说大致思路对了么?也对了,就是真的跑起来各种坑,后面稍微加点复杂的逻辑需求,她们也就傻眼了。

参考链接

OpenAI数学题介绍页面——https://openai.com/blog/grade-school-math/https://arxiv.org/pdf/2103.03874.pdf

https://arxiv.org/pdf/2110.14168.pdf

https://arxiv.org/pdf/2211.14275.pdf

公开的数据集——https://github.com/openai/grade-school-math

这篇笔记,感谢何晓楠,沈炜两位前同事,他们也做出了极大的贡献

记忆, 语言模型, 逻辑推理, 数学问题

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!