文章主题:

事实证明,如果你想解答一个脑筋急转弯问题,那你最好还是有一个人类的大脑。

ChatGPT 等人工智能系统因其卓越的表现而广受好评,它们在医疗诊断、智商测试以及概述科学论文等方面都有着出色的表现,因此获得了无数的赞誉。然而,《科学美国人》杂志却希望看到这个机器人与传奇谜题作家 Martin Gardner 的後人進行一场正面的交锋。值得一提的是,Martin Gardner 是该杂志的数学游戏专栏长期以来的一位作者,他於 2010 年离世。为了测试 ChatGPT 的能力,我使用了部分由 Gardner 编写的脑筋急转弯文本,并结合 2014 年数学家 Colm Mulcahy 和计算机科学家 Dana Richards 在《科学美国人》中对他工作的致敬题目进行了测试。

我们的测试成果喜忧参半,部分结果令人满意,部分则让人感到尴尬。然而,这种状况在一定程度上为我们提供了有价值的洞见,使我们能够更加深入地探讨ChatGPT以及类似人工智能系统的工作原理。

ChatGPT 是由 OpenAI 公司开发的一种大型语言模型,该模型的基础是深度学习技术。OpenAI 为 ChatGPT 提供了大量的文本数据,包括书籍、网站和其他类型的信息,这些数据被用于训练这个 AI 系统。在训练过程中,ChatGPT 学会识别最可能的词语,以便在下一个词语之前生成相应的响应。此外,人类训练系统还负责教导 ChatGPT 对用户提出的问题(特别是涉及敏感话题的问题)给出最佳答案。

仅此而已。

密歇根大学的数据科学伦理学家 Merve Hickok 对人工智能进行了严厉批评。她指出,人工智能并不具备推理能力,因为它无法理解上下文,也无法独立于其系统内置内容之外的东西。尽管它在某些方面表现像是进行推理,但这只是因为它的行为受到数据集的限制。

下面我们就用一些相对简单的谜题来说明硅芯片和碳基人脑灰质处理信息的方式之间有哪些关键区别。

谜题 1在本文中,我们将深入探讨一个真正具有挑战性的逻辑问题。如前面所述,2014年的致敬题目中描述了一个场景:在一栋建筑物内,共有三个开关分别位于一楼、二楼和三楼。其中,只有其中一个开关能控制三楼上的照明灯。而另外两个开关则没有任何连接。现在,请你根据这些信息,在不离开三楼的情况下,仅通过尝试一次,判断出哪个开关是有效的。

在输入问题描述给AI之后,AI立即提供了建议:首先,打开第一个开关一段时间,接着关闭它;然后,打开第二个开关并爬上楼梯。若灯光闪烁,第二个开关即为有效状态;反之,若灯熄灭但温度升高,第一个开关便是有效选项;而当灯熄灭且无任何温度变化时,第三个开关则是正确的选择。这一结论与我们在2014年得出的推理结果一致。

但根据密歇根大学计算机科学家 Kentaro Toyama 的说法,ChatGPT 在这种情况下轻松获胜,可能只是意味着它已经知道答案了——没法说它是自己研究出答案的。

“当它失败时,给出的结果看起来非常奇怪。但实际上我想到了它跑出正确逻辑的那些例子——这只是证明训练数据中有很多这样的逻辑,”Toyama 说。

谜题 2这次换一个数学成分更多的题目?Gardner 在他 1958 年 8 月的专栏中是这样出题的:“两枚导弹直接朝对方飞去,一枚的速度是每小时 9,000 英里,另一枚是每小时 21,000 英里。它们相距 1,317 英里。不使用铅笔和纸,计算出它们相撞前一分钟的距离。”

ChatGPT 在这道题上下了很大功夫。它展示了解决该难题关键部分——计算两枚导弹在一分钟内飞行的总距离——的两种不同解法。在两种解法中,它都给出了 500 英里这个正确结果,这本来也是谜题的最终答案。但 AI 不能忽略导弹一开始相距 1,317 英里这一事实,它一直试图从该距离中减去 500 英里,结果提供了错误的答案:导弹在坠毁前一分钟相距 817 英里。

我尝试在接下来的交流中鼓励 ChatGPT 找到正确答案。例如,我建议它以数学教授的方式回答问题,并明确地告诉它,刚才的答案是错误的。这些干预未能阻止 ChatGPT 提供错误的解决方案。但是,当被告知导弹之间的起始距离是一条红鲱鱼时,它确实对此调整了响应并找到了正确结果。

尽管如此,我还是怀疑人工智能是否真的学会了这里面的逻辑。我给了它同样的谜题,但把导弹变成了船并改变了数字——唉,ChatGPT 又一次被愚弄了。这给 Toyama 所说的问题提供了佐证,这个问题也是目前人工智能领域的一大争议:这些系统是否能够自己搞清楚逻辑。

“一个观点是,如果你给它提供这么多逻辑思维的例子,最终神经网络将自己学会理解逻辑思维,然后就能够在正确的实例中应用它,”Toyama 说。“还有些人认为,‘不,逻辑与神经网络目前的学习方式有着根本差异,因此你需要专门构建能理解逻辑的人工智能。’”

谜题 3我尝试的第三个谜题来自 1964 年 3 月 Gardner 的质数题目:“给定 1 到 9 这九个数字,每一个都只使用一次,形成一组三个质数,让它们的总和最小。例如,集合 941、827 和 653 的和为 2,421,但这远非最小值。”

判断较小的数字(例如 3、5、7 和 11)是否是质数相对容易。但数字越大,判断它是质数还是合数就越困难。

Gardner 在那年的下个月提出了一个特别优雅的解决方案:“我们首先尝试三个数字都是三位数的情况。这些数字的结尾必须是 1、3、7 或 9(这一规律适用于所有大于 5 的质数)。我们把 1 拿出来放到某个数字的百位,这样三个数字的个位就是 3、7、9。每个数字的百位最小选项是 1、2 和 4,这样剩下的十位数字就是 5、6 和 8。在符合这些规范的 11 个三位数质数中,不可能找到三个没有重复数字的质数组合。我们接下来尝试在百位使用 1、2 和 5 的组合,这样就能产生唯一的答案:149+263+587=999。

AI 的第一个答案给我留下了深刻的印象:257、683 和 941。它们都是质数,总和为 1,881。这是一个相当小的结果,但还是大于 Gardner 的方案。但不幸的是,当我要求 ChatGPT 解释它的推理过程时,它提供的冗长过程通向另一个结果:数字 109、1,031 和 683。三个数字都是质数,但不符合题设要求。

然后我提醒它回想起一开始的答案,结果 ChatGPT 提供了一个愚蠢的解释,包括声称“我们不能使用 1、4 或 6 作为三位数素数的第一位,因为所得数字可以被 3 整除。”这显然是错误的:能被 3 整除的数字应该是各个位的数字总和可以被 3 整除才对。

我尝试给它打气,指出有更好的解决方案,并建议 ChatGPT 想象它自己是一位数学教授,但它接下来提供的结果是 2、3 和 749。然后它偶然发现了 359、467 和 821——另一个有效的组合,总计 1,647——比第一个解更好,但仍不如 Gardner 的解优雅。

很遗憾,这是我能得到的最好结果。另外六个答案充满了非质数和缺失或多余的数字。然后 ChatGPT 再次提供了 257、683 和 941 这个结果。

所有这些失败都反映了 Toyama 提到的这类人工智能系统的一个关键特性。“ChatGPT 擅长拟人化,”他说。“它掌握了人类的语言风格,但它没有被输入明确的程序来做那些计算机一直非常擅长的事情,也就是很像食谱的演绎逻辑。”它并没有解决问题,甚至不一定要尝试解决问题——它只是大致展示了解决方案的样子。

在整个尝试过程中,令我震惊的是,似乎没有任何事情能让 AI 感到慌张。但 Toyama 表示,这也反映了 ChatGPT 的打造过程及过程中给它输入的材料的样子。“你可以想象一下,用来训练它的绝大多数文本的平均语气应该是什么样的,——可能那个平均语气是相当自信的,”他说。

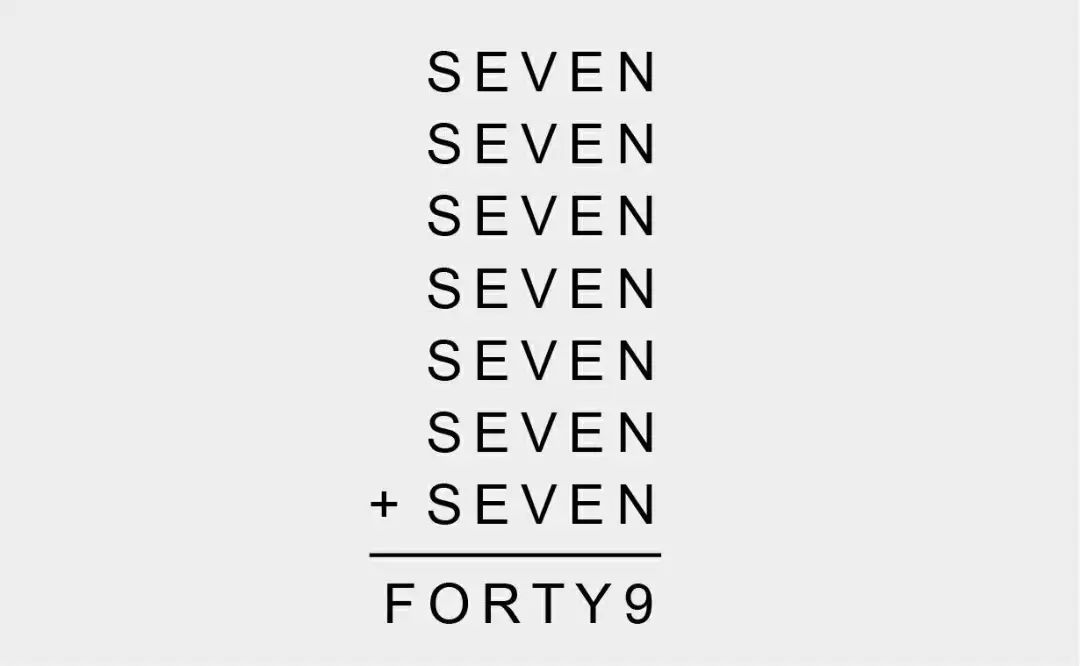

谜题 42014 年致敬题目的最后一道:“每个字母对应一个数字……如果算式成立,你能算出每个字母代表哪个数字吗?”

这看起来既优雅又有趣!那么 AI 的答案到底能有多糟糕?唉,ChatGPT 的第一反应是“11111+11111+11111+11111+11111+11111+11111=FORTY9”。

AI 的下一个尝试承认了这个谜题需要把字母换成数字,但我花了好几轮说服这个聊天机器人不要在每个 SEVEN 中删除第二个 E。ChatGPT 似乎偶然发现了一个组合,其中包括 N=7——这是正确的。简直就是奇迹,因为这是正确解决方案的第一步。

我向它确认 N=7 是正确的,但 AI 显然是在随机猜测。(如果它要尝试特定的数字,它应该从测试 E 的不同解决方案开始。最简单的起始步骤——剧透警报——是测试 E=0 是否成立,ChatGPT 完全没有考虑到这一点。)它承诺给出系统的解决方案,然后假设 S=1,又开始随机猜测了。虽然我想分享它尝试过程的剩余部分,但它实在太荒谬了,最后的结尾告诉我“再次更新方程式:116”,简直是在梦游。

ChatGPT 接下来的表现更糟了。它假设 S=9,这是我让它尝试的。它假定因为 N+N+N+N+N+N+N=9,所以 N=1。它说七个 E 的总和必须等于 2,所以 E=2。它甚至提出 S=4⁄7,不过下面就很有礼貌地否定了自己。我最后丧失了信心,所以我决定给它更多帮助。我给 ChatGPT 提供了一个线索:S=3。我也提醒机器人 N=7,但这些提示只是让它给出了四个越发混乱的答案。

这团乱麻和刚才一样很能说明问题,因为它展示了人工智能是如何处理它接收到的各种事实集合的。在这个例子中,虽然聊天机器人似乎忘记了我说的 N=7 这个提示,但 Toyama 认为它实际上是在纠结逻辑。“在那之后它给你的反应听起来都很合理,”他说,“但它们可能会,也可能不会考虑到事实的正确组合,或以正确的方式将它们组合在一起。”

Toyama 说,事实上,你不需要这么复杂的谜题,就能看到 ChatGPT 是如何与逻辑斗争的。只需让它将两个大数相乘即可。“这可以说是你能问它的最简单的逻辑问题之一;这是一道简单的算术题,”他说。“它不仅错了一次,还错了很多次,而且错误的方式五花八门。”那是因为即使 ChatGPT 可能已经分析了大量的数学教科书,但没有人教给它一个无限大的乘法表。

尽管遇到了困难,但 AI 聊天机器人在脑筋急转弯中取得了一项关键的逻辑突破。“看来我目前无法准确解决给定的脑筋急转弯,”当我告诉它,它在解决最后一个问题时似乎已经黔驴技穷时,ChatGPT 这样回答我。“对于我给你带来的困惑,我深表歉意。最好以全新的视角来处理问题,或咨询其他资源以找到正确的解决方案。”

原文链接:

https://www.scientificamerican.com/article/you-can-probably-beat-chatgpt-at-these-math-brainteasers-heres-why/

你也「在看」吗? ?

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!